La rilevazione non distruttiva dei frutti attaccati da insetti è un tema di grande interesse per la biosicurezza e la qualità delle filiere ortofrutticole.

Nel caso della Queensland fruit fly (Qfly, Bactrocera tryoni), un insetto parassita pericoloso per il commercio internazionale ortofrutticolo, la difficoltà nell’identificazione deriva dal fatto che i segni di ovideposizione sono spesso minimi e difficili da distinguere a occhio nudo rispetto a pigmentazioni naturali o a lievi danni meccanici.

Un recente studio ha proposto un approccio innovativo che integra tecniche di imaging ottico avanzato e algoritmi di intelligenza artificiale per ottenere una rilevazione affidabile delle punture da ovideposizione sulle ciliegie fresche.

Immagini iperspettrali e lunghezza d’onda

Attraverso l’utilizzo di immagini iperspettrali (HSI), i ricercatori hanno identificato la lunghezza d’onda di 730 nm come ottimale per discriminare le lesioni da ovideposizione rispetto ad altre irregolarità superficiali del frutto.

Questa scelta deriva dall’evidenza che, a 730 nm, le aree danneggiate assumono caratteristiche particolari: spot scuri con un centro biancastro, mentre pigmentazioni e difetti non parassitari risultano meno visibili.

Sulla base di questa informazione, è stata sviluppata la prima libreria di immagini NIR ad alta risoluzione e singola lunghezza d’onda dedicate alla Qfly, la quale comprende oltre 1700 immagini acquisite mediante microscopio e camera modificata per il vicino infrarosso (NIR).

Gli spot di ovideposizione sono stati annotati manualmente, generando oltre 13.000 bounding box e più di 120.000 patch di training, un dataset senza precedenti per dimensioni e specificità.

Framework di machine learning

La novità non risiede solo nell’approccio di acquisizione, ma soprattutto nella metodologia di analisi.

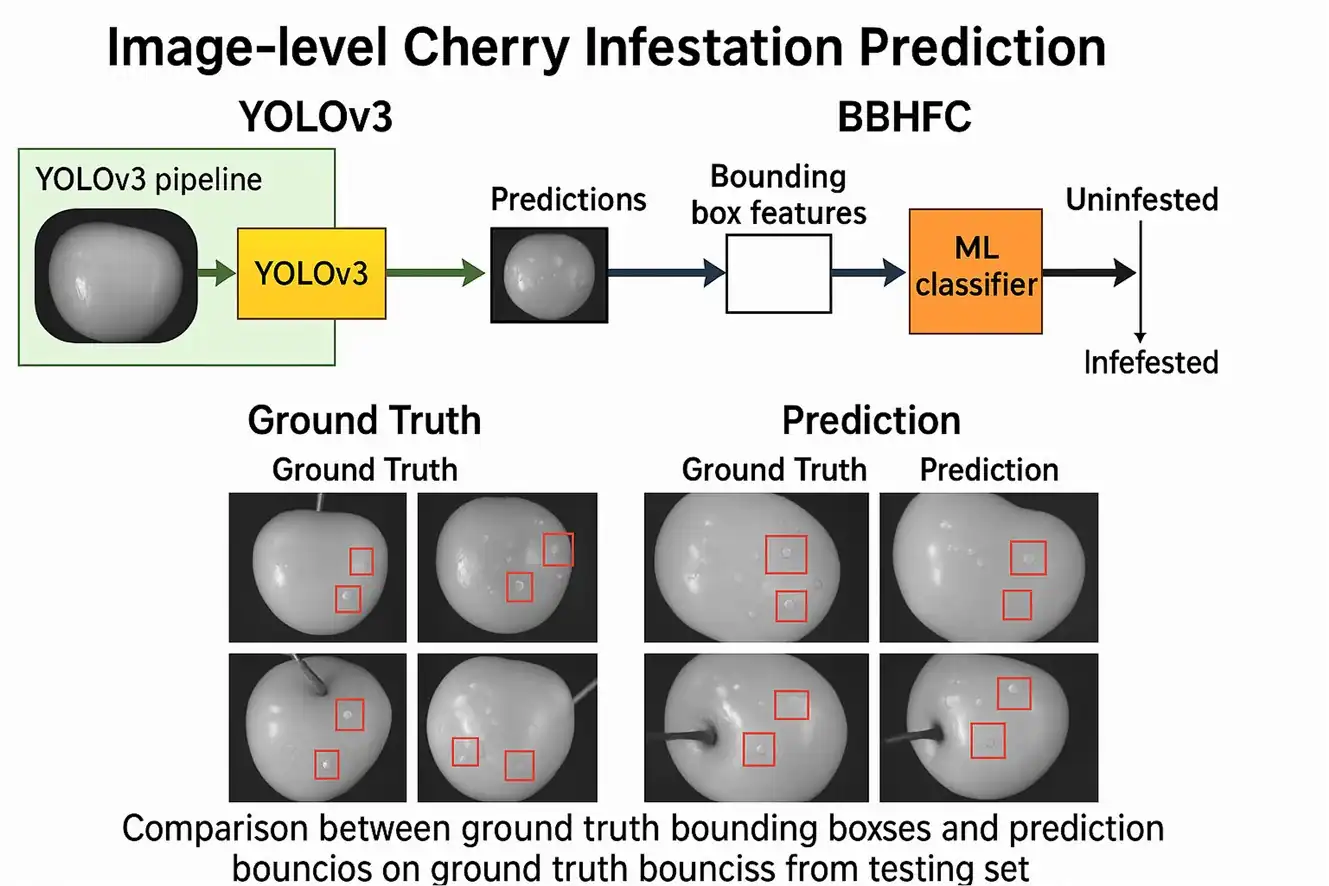

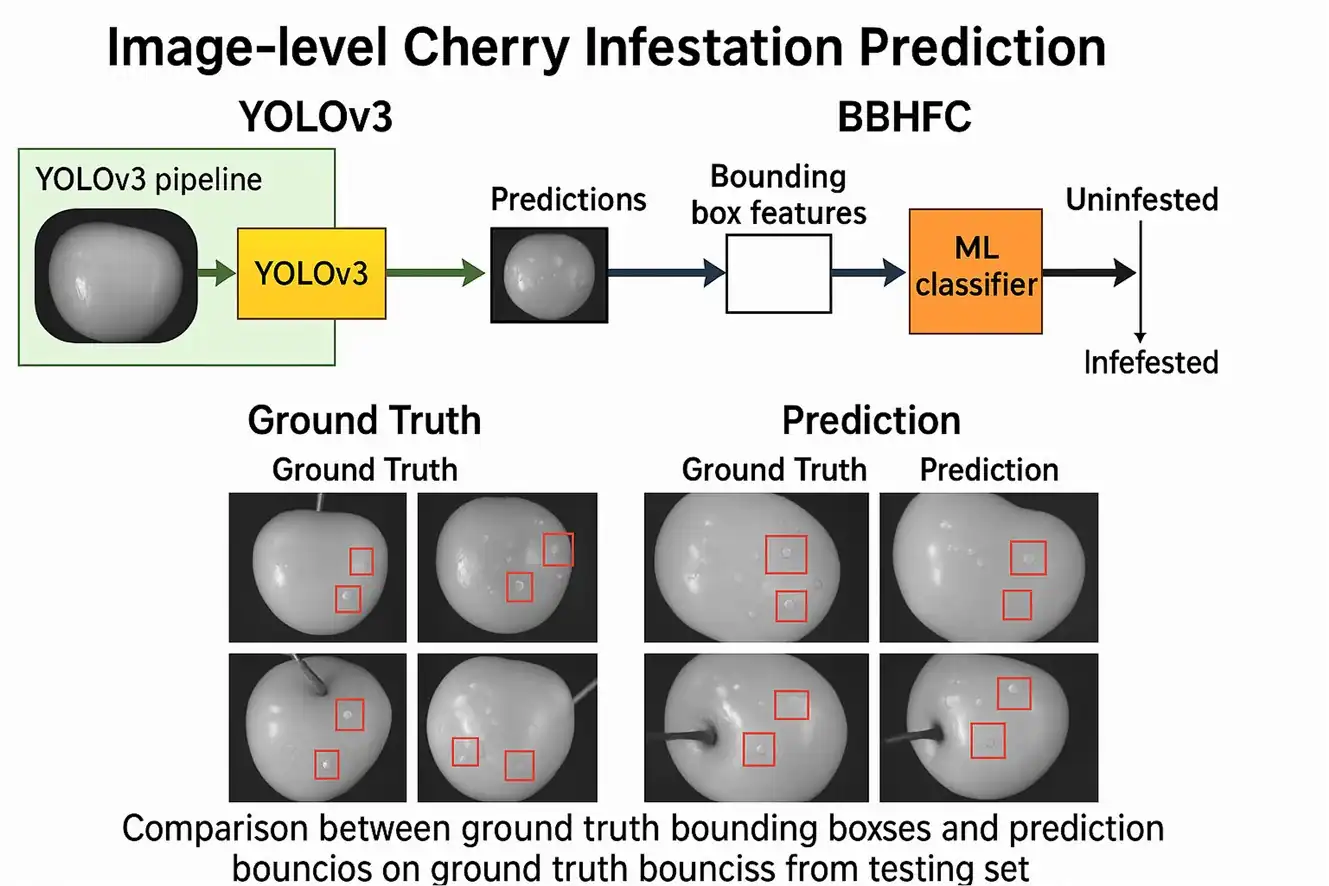

I ricercatori hanno sviluppato un framework di machine learning (ML), denominato Bounding Box Histogram Fusion Classifier (BBHFC), che sfrutta l’output di un modello YOLOv3 addestrato per individuare le punture di ovideposizione.

Invece di basarsi su una soglia di decisione sulle predizioni dell’object detector (approccio YOLO-IP), BBHFC trasforma i bounding box prodotti da YOLO in vettori di caratteristiche basati su istogrammi di confidenza e classi, successivamente utilizzati da classificatori tradizionali come decision tree, random forest o SVM.

Questo approccio riduce drasticamente la sensibilità alle soglie di confidenza e consente prestazioni più robuste nell’identificazione dei frutti colpiti.

Prestazioni del modello BBHFC

I risultati mostrano che il sistema BBHFC supera significativamente YOLO-IP in termini di accuratezza, sensibilità e specificità, raggiungendo valori (F1 score) superiori a 0,93 a livello di immagine e oltre 0,89 a livello di frutto.

Il modello con decision tree ha ottenuto, in particolare, un equilibrio ottimale tra sensibilità (0.9689) e specificità (0.9544).

Il confronto con l’ispezione visiva umana ha mostrato risultati molto interessanti: cinque ispettori, valutando 155 ciliegie artificialmente infestate inserite in lotti di controllo, hanno raggiunto un’accuratezza media del 60%, mentre il modello BBHFC ha superato l’89%.

Questo divario evidenzia l’enorme potenziale delle tecnologie di imaging NIR combinate con algoritmi di AI per supportare o integrare l’occhio umano nelle fasi di grading, nei controlli fitosanitari e nelle ispezioni pre- e post-border, attività particolarmente costose ma fondamentali per il commercio internazionale.

Prospettive e sviluppi futuri

In conclusione, la fattibilità tecnica e operativa dell’imaging NIR a singola lunghezza d’onda risulta ottima, soprattutto come alternativa economica e rapida all’imaging iperspettrale, che è oggi poco applicabile in contesti industriali per costi e tempi di acquisizione.

Il framework BBHFC si distingue per modularità e scalabilità, aprendo la strada a possibili integrazioni nei sistemi di selezione ottica attualmente presenti nei magazzini di lavorazione frutta.

Ulteriori sviluppi riguarderanno la riduzione del tasso di falsi positivi, l’automatizzazione delle procedure di etichettatura e la valutazione della tecnologia in flussi reali ad alta velocità, prerequisiti essenziali per una futura adozione commerciale.

Fonte: Yazdani, M., Bao, D., Zhou, J., Wang, A., & van Klinken, R. D. (2025). Single-Wavelength Near-Infrared Imaging and Machine Learning for Detecting Queensland Fruit Fly Damage in Cherries. Smart Agricultural Technology, 101090. https://doi.org/10.1016/j.atech.2025.101090

Fonte immagini: Yazdani et al., 2025

Andrea Giovannini

Università di Bologna

Cherry Times - Tutti i diritti riservati